|  | ||||

|  |

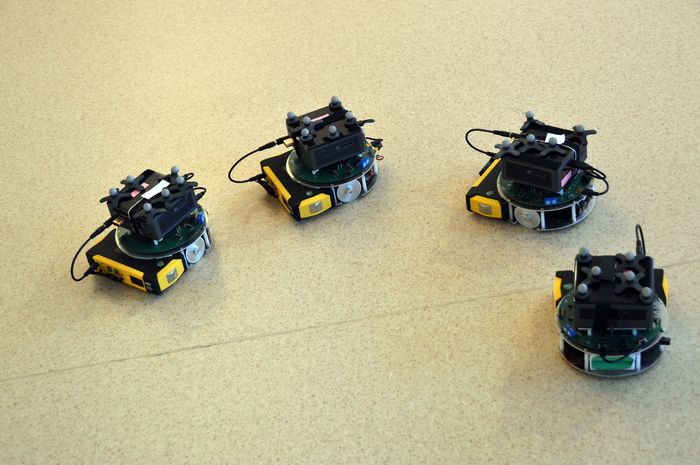

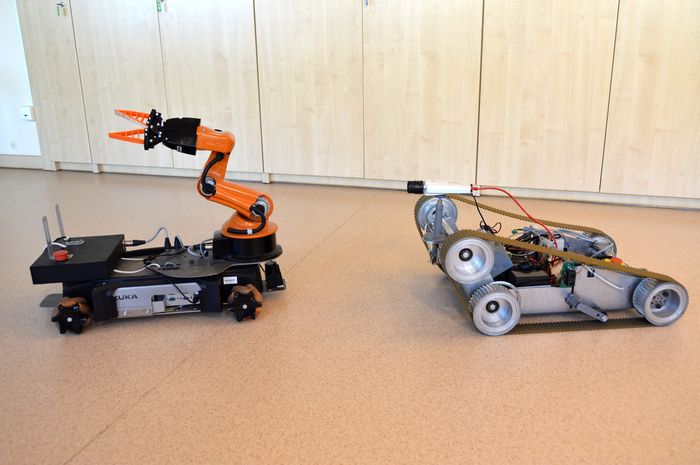

W Laboratorium Robotyki Mobilnej i Systemów Wizyjnych znajduje się 8 stanowisk dydaktycznych z komputerami PC w konfiguracji Intel Core i5-6500, 8GB RAM, 500GB SDD z systemami Windows oraz Linux z ROS, środowiskiem Matlab/Simulink, Visual Studio. Zainstalowany jest również system wizyjny OptiTrack do lokalizacji obiektów w przestrzeni 3D za pomocą pasywnych znaczników mocowanych na obiektach. W skład systemu wchodzi 10 kamer Prime 17W i switch NETGEAR M4100-12G-POE+ łączący kamery z komputerem stanowiącym serwer wizyjny (Intel Xeon E5-1620v3). Serwer wizyjny w sieci lokalnej w laboratorium udostępnia wyniki pomiarów do wszystkich stanowisk komputerowych w laboratorium. Na wyposażeniu do zajęć dydaktycznych dostępne są roboty mobilne Kheppera III, MTracker (roboty własnej konstrukcji w wersjach z procesorem DSP oraz DSP+komputer pokładowy PC), do prac projektowych robot KUKA YouBot, Roksis, platformy Jet Racer, skanery laserowe Hokuyo, Slamtec oraz kamery Intel Realsense i uEye w różnych konfiguracjach do systemów wizyjnych stacjonarnych i wbudowanych.

W laboratorium znajduje się również stanowisko badawcze z dwoma komputerami Intel Core i7 dedykowane do prac dotyczących sterowania robotami mobilnymi z przyczepami, w którym wykorzystuje się wizyjny system lokalizacji ostatniej przyczepy w oparciu o aktywne znaczniki diodowe w oparciu o jedną kamerę lub system OptiTrack. Badania eksperymentalne prowadzi się wykorzystując roboty RMP konstrukcji własnej złożone z ciągnika i maksymalnie 3 przyczep (dwa zestawy). W laboratorium dostępne są dwa projektory ACER H6517ST, jeden używany do projekcji środowiska na potrzeby stanowiska badawczego, drugi do prezentacji wykorzystywany w pracach badawczych i dydaktyce.

W laboratorium prowadzone są następujące zajęcia laboratoryjne i projektowe:

Przetwarzanie obrazów i systemy wizyjne - w ramach laboratorium studenci korzystają ze środowiska Matlab do weryfikacji działania różnych metod przetwarzania obrazu wykorzystując techniki punktowe, kontekstowe, filtrację liniową i nieliniową, operacje morfologiczne, kompresję obrazu. Realizują ćwiczenia związane z akwizycją obrazów z kamer, rozpoznawaniem wybranych znaczników dla robotów mobilnych.

Sterowanie robotów mobilnych - w trakcie zajęć studenci korzystają ze środowiska Matlab/Simulink do modelowania robota klasy (2,0), implementacji i syntezy parametrycznej obwodów regulacji kół oraz symulacyjnej weryfikacji jakości sterowania takim robotem w układzie otwartym. W dalszej części, korzystając z systemów szybkiego prototypowania, studenci implementują i testują poznane algorytmy sterowania robotem mobilnym klasy (2,0) dla klasycznych zadań ruchu z wykorzystaniem fizycznych platform mobilnych (Kheppera III i MTracker).

Nawigacja i planowanie ruchu robotów - zajęcia laboratoryjne dotyczą analizy błędów i weryfikacji dokładności wybranych metod lokalizacji robotów, badania czujników pomiarowych wykorzystywanych w lokalizacji, projektowania i implementacji układów pomiarowych do zadania lokalizacji z wykorzystaniem mikrokontrolerów i procesorów DSP, zastosowania metod fuzji danych. W ramach zajęć przedstawiane są systemy operacyjne robotów mobilnych i ich zastosowania w zadaniu lokalizacji, mapowaniu środowiska i nawigacji, badania laboratoryjne ilustrujące działania tych metod na obiektach rzeczywistych. Implementacja programowa metod planowania ruchu jest realizowana w środowisku Matlab/Simulink oraz w języku C/C++.

Robotyka mobilna - laboratorium dotyczy modelowania kinematyki i dynamiki robotów kołowych w środowisku symulacyjnym, implementacji wybranych algorytmów sterowania ruchem dla robotów rzeczywistych z uwzględnieniem metod liniowych i nieliniowych. Wykonania analizy jakościowej algorytmów sterowania ruchem i porównania algorytmów. Badania odometrii i oceny propagacji błędów metody.

Fundamentals of Autonomous Systems - w ramach zajęć studenci zajmują się modelowaniem w środowisku symulacyjnym kinematyki i dynamiki robotów kołowych oraz implementacją wybranych algorytmów sterowania ruchem dla fizycznych robotów z uwzględnieniem metod liniowych i nieliniowych. Dokonują analizy jakościowej algorytmów sterowania ruchem, przeprowadzają porównanie algorytmów. Implementują wybrane algorytmy percepcji środowiska na podstawie danych sensorycznych (wirtualnych i rzeczywistych). Badają wybrane algorytmy planowania ruchu.

Sensor Integration - studenci realizują symulacyjne przykłady wybranych metod filtracji przygotowanych sygnałów w celu optymalnej i suboptymalnej estymacji stanu w środowisku symulacyjnym Matlab/Simulink. Zajmują się praktyczną implementacją oprogramowania wykorzystującego techniki fuzji danych dla akwizycji pomiarów z wybranych czujników.

Control of Underactuated Systems - zajęcia projektowe dotyczą modelowania kinematyki i dynamiki układów niedosterowanych oraz implementacji wybranych algorytmów sterowania tych układów w środowisku symulacyjnym.

Design of Control Systems - w ramach zajęć studenci zajmują się wybranymi zagadnieniami związanymi z modelowaniem, sterowaniem czy systemami pomiarowymi. Projekty, w zależności od złożoności problemu, prowadzone są w środowisku symulacyjnym, z wykorzystaniem narzędzi szybkiego prototypowania lub implementowane z użyciem układów fizycznych.

Vision Based Control - w trakcie zajęć projektowych studenci wykonują zadania związane z akwizycją i przetwarzaniem obrazów z kamer pod kątem implementacji wizyjnego sprzężenia zwrotnego w sterowaniu robotów mobilnych. Projekty są realizowane z użyciem narzędzi szybkiego prototypowania Matlab/Simulink, środowiska Visual Studio, biblioteki OpenCV oraz systemu Linux i ROS.

Systemy teleoperacyjne - studenci poznają takie zagadnienia jak wykorzystanie protokołów komunikacyjnych do wymiany informacji między konsolą operatorską a robotem, projektują ramki danych i implementują komunikację. Zajmują się dekompozycją zadania na funkcjonalności realizowane przez różne elementy systemu i implementacją zaprojektowanych komponentów systemu teleoperacyjnego.

Systemy pomiarowe w automatyce i robotyce - laboratorium dotyczy statystycznej analizy danych pomiarowych, obserwatorów stanu i ich zastosowanie do estymacji stanu obiektu, fuzji danych. Projektowania analogowego toru wejściowego i wyjściowego. Tworzenia oprogramowania niskopoziomowego odpowiedzialnego za komunikację z czujnikiem i cyfrowy przesył danych do urządzenia nadrzędnego. Implementacji cyfrowych algorytmów przetwarzania sygnałów i obserwatorów.